11个最佳AI代理框架

本综合指南探讨了今天可用的11个最佳人工智能代理框架,比较它们的功能、优势、劣势和理想用例,以帮助您为下一个项目做出明智的决定。

人工智能代理已经彻底改变了软件开发人员构建智能应用程序的方式。这些人工智能代理框架提供了构建自主系统的基础设施、工具和方法论,这些系统能够推理、规划并执行复杂的任务,而无需大量的人类干预。

到2025年,人工智能代理已从简单的聊天机器人发展为能够进行多步推理、工具使用和协作解决问题的复杂系统。对于希望利用这项技术的开发人员来说,选择合适的框架对于项目的成功至关重要。

本综合指南探讨了今天可用的11个最佳人工智能代理框架,比较它们的功能、优势、劣势和理想用例,以帮助您为下一个项目做出明智的决定。

1、Langchain

LangChain 是一个开源框架,已成为构建人工智能驱动应用程序最受欢迎的选择之一。它将语言模型与各种工具、API 和外部数据源连接起来,以创建强大的人工智能代理。LangChain 最受喜爱的功能是其无缝地将多个大型语言模型(LLM)调用链连接在一起,并将其与外部数据源、工具和 API 集成的能力。这种模块化和可组合的方法允许开发人员以比直接使用原始 LLM API 更大的灵活性和简便性来构建复杂的多步骤人工智能应用程序——例如聊天机器人、代理和检索增强生成(RAG)系统。

主要功能:

- 为复杂任务设计智能系统

- 具有细粒度控制工作流的代理功能

- 支持多代理交互

- 人类在回路中的干预

- 与外部工具和 API 的无缝集成

优点:

- 强大且灵活的框架

- 开源且社区支持强大

- 支持复杂的任务处理

- 提供实时信息收集

- 对人工智能代理提供细粒度控制

缺点:

- 需要高级编程技能

- 设计复杂的代理可能很复杂

- 取决于底层 LLM 的能力

使用案例:

- 开发智能应用程序

- 创建自主任务解决系统

- 构建复杂的多步骤工作流代理

- 将人工智能能力集成到现有软件中

代码示例:

from langchain.agents import Tool, AgentExecutor, create_react_agent

from langchain.tools.ddg_search import DuckDuckGoSearchRun

from langchain_openai import ChatOpenAI

# Define tools the agent can use

search_tool = DuckDuckGoSearchRun()

tools = [

Tool(

name="Search",

func=search_tool.run,

description="Useful for searching the internet for current information"

)

]

# Initialize the language model

llm = ChatOpenAI(model="gpt-4")

# Create the agent with the React framework

agent = create_react_agent(llm, tools, "You are a helpful AI assistant.")

# Create an agent executor

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# Run the agent

response = agent_executor.invoke({"input": "What are the latest developments in AI agent frameworks?"})

print(response["output"])2、AutoGen

AutoGen 是由微软研究开发的开源编程框架,旨在构建和管理具有高级协作能力的人工智能代理。

AutoGen 的基于演员的架构及其对代理协作的关注经常被引用为变革性的,使得在业务流程自动化、金融、医疗保健等领域构建新的类 AI 解决方案变得更加容易。这种对专业化、可交谈和可定制代理的协调被广泛认为是用户最欣赏的功能,因为它使得构建复杂、可扩展且可靠的 AI 应用程序变得更加容易。

主要功能:

- 多代理协作(包括人机协作和完全自治)

- 与大型语言模型(LLMs)集成

- 代码执行和调试支持

- 可扩展性和分布式计算

- 异步消息传递

- 自主和交互式工作流

优点:

- 流程化创建和管理 AI 代理系统

- 简化构建能够协作和推理的 AI 系统

- 允许代理之间的交互以解决复杂问题

缺点:

- 相对较新的框架(正在进行开发)

- 设置多代理交互可能比较复杂

- 根据代理配置的不同,性能可能会有所变化

使用案例:

- 软件开发

- 复杂任务解决

- 交互式 AI 系统设计

- 研究和开发环境

代码示例:

import autogen

# Define LLM configuration

llm_config = {

"config_list": [{"model": "gpt-4", "api_key": "your-api-key"}]

}

# Create an AssistantAgent

assistant = autogen.AssistantAgent(

name="assistant",

llm_config=llm_config,

system_message="You are a helpful AI assistant."

)

# Create a UserProxyAgent

user_proxy = autogen.UserProxyAgent(

name="user_proxy",

human_input_mode="TERMINATE", # Auto-reply with TERMINATE when the task is done

max_consecutive_auto_reply=10,

is_termination_msg=lambda x: x.get("content", "").rstrip().endswith("TERMINATE"),

code_execution_config={"work_dir": "coding"}

)

# Initiate chat between agents

user_proxy.initiate_chat(

assistant,

message="Write a Python function to calculate the Fibonacci sequence."

)3、CrewAI

CrewAI 是一个用 Python 构建的开源多代理编排框架,专为构建协作的人工智能代理系统而设计,这些代理像真正的团队一样协同工作。

主要功能:

- 带有特定角色、工具和目标的代理协作

- 可定制的代理,带有定义好的人格

- 高级简单性与精确低级控制相结合

- 跨行业的流程自动化支持

- 与各种 LLMs 和云平台兼容

优点

- 代理设计的灵活性

- 实现的简单性

- 支持复杂、协作的任务完成

- 模块化和可重用的代理架构

缺点

- 需要 Python 编程知识

- 相对较新的框架(可能社区支持有限)

- 设计复杂的代理交互可能比较复杂

使用案例

- 流程自动化

- 支持机器人创建

- 复杂的研究和分析任务

- 专业团队模拟

- 业务流程优化

代码示例

from crewai import Agent, Task, Crew

from langchain_openai import ChatOpenAI

# Initialize the language model

llm = ChatOpenAI(model="gpt-4")

# Define agents with specific roles

researcher = Agent(

role="Research Analyst",

goal="Discover and analyze the latest trends in AI technology",

backstory="You are an expert in AI research with a keen eye for emerging trends",

verbose=True,

llm=llm

)

writer = Agent(

role="Technical Writer",

goal="Create comprehensive reports based on research findings",

backstory="You are a skilled technical writer who can explain complex concepts clearly",

verbose=True,

llm=llm

)

# Define tasks for each agent

research_task = Task(

description="Research the latest developments in AI agent frameworks",

expected_output="A comprehensive analysis of current AI agent frameworks",

agent=researcher

)

writing_task = Task(

description="Write a detailed report on AI agent frameworks based on the research",

expected_output="A well-structured report on AI agent frameworks",

agent=writer,

context=[research_task] # The writing task depends on the research task

)

# Create a crew with the agents and tasks

crew = Crew(

agents=[researcher, writer],

tasks=[research_task, writing_task],

verbose=True

)

# Execute the crew's tasks

result = crew.kickoff()

print(result)4. Semantic Kernel

微软的 Sementic Kernal 允许用户构建人工智能代理并将最新的 AI 模型集成到 C#、Python 或 Java 中。

Semantic Kernel 是一个开源开发套件,用于构建人工智能代理,支持多种编程语言,并能集成 AI 模型和服务。

主要功能

- 与多个提供商(OpenAI、Azure OpenAI、Hugging Face)集成 AI 服务

- 支持各种代理类型的代理框架

- 轻量级且灵活的架构

- 企业级支持

- 多代理系统功能

优点:

- 模块化架构

- 易于使用的开发方法

- 支持复杂工作流创建

- 能够将 AI 嵌入现有的开发过程中

缺点:

- 相对较新的框架

- 需要理解 AI 集成的概念

- 对新接触 AI 框架的开发者可能有学习曲线

使用案例:

- 企业 AI 解决方案

- 自定义 AI 代理开发

- 工作流自动化

- AI 驱动的应用程序集成

代码示例:

import semantic_kernel as sk

from semantic_kernel.connectors.ai.open_ai import OpenAIChatCompletion

# Initialize the kernel

kernel = sk.Kernel()

# Add OpenAI service

api_key = "your-api-key"

model = "gpt-4"

kernel.add_chat_service("chat_completion", OpenAIChatCompletion(model, api_key))

# Create a semantic function using natural language

prompt = """

Generate a creative story about {{$input}}.

The story should be engaging and approximately 100 words.

"""

# Register the function in the kernel

story_function = kernel.create_semantic_function(prompt, max_tokens=500)

# Execute the function

result = story_function("a robot learning to paint")

print(result)

# Create a simple agent using Semantic Kernel

from semantic_kernel.planning import ActionPlanner

# Define the planner

planner = ActionPlanner(kernel)

# Execute a plan

plan = await planner.create_plan("Write a poem about artificial intelligence")

result = await plan.invoke()

print(result)5、LangGraph

LangGraph 是 LangChain 创建的一个开源人工智能代理框架,用于构建和管理复杂的生成式 AI 工作流。

主要功能:

- 先进的代理模式(工具调用、React 方法、自我询问方法)

- 节点(LLMs)和边(工具)的可视化表示

- 对工作流流和状态的精细控制

- 灵活的框架用于构建状态应用程序

- 支持复杂的多代理场景

优点:

- 专门的基础设施用于基于语言的人工智能代理

- 能够创建复杂、相互关联的代理系统

- 支持复杂的流程设计和管理

缺点:

- 可能需要高级开发人员技能

- 主要专注于基于语言的工作流

使用案例:

- 会话代理

- 复杂任务自动化

- 自定义 LLM 支持的工作流

- 基于语言处理的人工智能代理开发

代码示例:

from typing import TypedDict, Annotated, Sequence

from langgraph.graph import StateGraph, END

from langchain_openai import ChatOpenAI

from langchain_core.messages import HumanMessage, AIMessage

# Define the state structure

class AgentState(TypedDict):

messages: Annotated[Sequence[HumanMessage | AIMessage], "The messages in the conversation"]

next_step: Annotated[str, "The next step to take"]

# Initialize the language model

llm = ChatOpenAI(model="gpt-4")

# Define the nodes (steps in the workflow)

def research(state: AgentState) -> AgentState:

messages = state["messages"]

response = llm.invoke(messages + [HumanMessage(content="Research this topic thoroughly.")])

return {"messages": state["messages"] + [response], "next_step": "analyze"}

def analyze(state: AgentState) -> AgentState:

messages = state["messages"]

response = llm.invoke(messages + [HumanMessage(content="Analyze the research findings.")])

return {"messages": state["messages"] + [response], "next_step": "conclude"}

def conclude(state: AgentState) -> AgentState:

messages = state["messages"]

response = llm.invoke(messages + [HumanMessage(content="Provide a conclusion based on the analysis.")])

return {"messages": state["messages"] + [response], "next_step": "end"}

# Create the graph

workflow = StateGraph(AgentState)

# Add nodes

workflow.add_node("research", research)

workflow.add_node("analyze", analyze)

workflow.add_node("conclude", conclude)

# Add edges

workflow.add_edge("research", "analyze")

workflow.add_edge("analyze", "conclude")

workflow.add_edge("conclude", END)

# Set the entry point

workflow.set_entry_point("research")

# Compile the graph

agent = workflow.compile()

# Execute the workflow

result = agent.invoke({

"messages": [HumanMessage(content="Tell me about AI agent frameworks")],

"next_step": "research"

})

# Print the final messages

for message in result["messages"]:

print(f"{message.type}: {message.content}\n")6、LlamaIndex

LlamaIndex 是一个灵活的开源数据编排框架,专门用于整合私有和公共数据以供 LLM 应用程序使用。

主要功能:

- 将 AI 代理功能作为“自动推理和决策引擎”

- 函数调用能力

- 与各种格式的数据交互

- 工具集成

- 支持多模态应用(文本、图像、其他数据类型)

优点:

- 简单且灵活的框架

- 支持整合多样化的数据源

- 支持自定义 AI 代理开发

- 开源且可适应性强

缺点:

- 可能需要高级技术知识

- 需要了解 LLM 和代理开发的概念

使用案例:

- 企业知识助手

- 自主 AI 代理

- 复杂的数据交互和分析

- 构建生产就绪的 AI 应用程序

代码示例:

from llama_index.core.agent import FunctionCallingAgentWorker

from llama_index.core.tools import FunctionTool

from llama_index.llms.openai import OpenAI

# Define a simple tool function

def search_documents(query: str) -> str:

"""Search for information in the document database."""

# In a real application, this would query a document store

return f"Here are the search results for: {query}"

# Create a function tool

search_tool = FunctionTool.from_defaults(

name="search_documents",

fn=search_documents,

description="Search for information in the document database"

)

# Initialize the language model

llm = OpenAI(model="gpt-4")

# Create the agent

agent = FunctionCallingAgentWorker.from_tools(

[search_tool],

llm=llm,

verbose=True

)

# Run the agent

response = agent.chat("Find information about AI agent frameworks")

print(response)7、OpenAI Agents SDK

OpenAI Agents SDK 是一个基于 Python 的工具包,用于构建能够推理、计划并采取行动以完成复杂任务的智能自主系统。

主要功能:

- 代理循环功能(处理工具调用、将结果发送给 LLM)

- 工具集成(将 Python 函数转换为代理可用的工具)

- 追踪能力,用于可视化代理工作流

优点:

- 流程化代理开发方法

- 内置可视化代理工作流

- 步骤跟踪代理操作

缺点:

- 依赖于 OpenAI 的基础设施

- 需要高级 Python 编程技能

- 可能受限于 OpenAI 当前的技术限制

使用案例:

- 客户支持自动化

- 多步骤研究过程

- 内容生成

- 复杂任务管理

代码示例:

from openai import OpenAI

import json

# Initialize the OpenAI client

client = OpenAI(api_key="your-api-key")

# Define a tool

tools = [

{

"type": "function",

"function": {

"name": "search_weather",

"description": "Get the current weather in a given location",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "The city and state, e.g., San Francisco, CA"

}

},

"required": ["location"]

}

}

}

]

# Function to handle the weather search tool

def search_weather(location):

# In a real application, this would call a weather API

return f"The weather in {location} is currently sunny with a temperature of 72°F."

# Create an agent that uses the tool

messages = [{"role": "user", "content": "What's the weather like in Boston?"}]

response = client.chat.completions.create(

model="gpt-4",

messages=messages,

tools=tools,

tool_choice="auto"

)

# Process the response

response_message = response.choices[0].message

messages.append(response_message)

# Check if the model wants to call a function

if response_message.tool_calls:

# Process each tool call

for tool_call in response_message.tool_calls:

function_name = tool_call.function.name

function_args = json.loads(tool_call.function.arguments)

# Call the function

if function_name == "search_weather":

function_response = search_weather(function_args.get("location"))

# Append the function response to messages

messages.append({

"tool_call_id": tool_call.id,

"role": "tool",

"name": function_name,

"content": function_response

})

# Get a new response from the model

second_response = client.chat.completions.create(

model="gpt-4",

messages=messages

)

print(second_response.choices[0].message.content)

else:

print(response_message.content)8、Atomic Agents

Atomic Agents 是一个轻量级、模块化的框架,用于构建强调人工智能代理开发原子性的 AI 代理管道。

主要功能:

- 模块化允许组合小型、可重用的组件

- 通过使用 Pydantic 清晰的输入/输出模式实现可预测性

- 可扩展性,用于集成新组件

- 支持多代理系统开发

优点:

- 轻量级架构

- 高度灵活的代理构建

- 对人工智能代理组件的细粒度控制

- 开源且对开发者友好

缺点:

- 相对较新的框架(暗示潜在的不断发展的生态系统)

使用案例:

- 构建复杂的 AI 应用程序

- 开发多代理系统

- 创建模块化的 AI 管道

- 研究和分析任务

代码示例:

from pydantic import BaseModel, Field

from typing import List

import os

# This is a simplified example based on Atomic Agents' approach

# In a real implementation, you would import from the atomic_agents package

# Define input/output schemas

class ResearchQuery(BaseModel):

topic: str = Field(description="The topic to research")

depth: int = Field(description="The depth of research required (1-5)")

class ResearchResult(BaseModel):

findings: List[str] = Field(description="Key findings from the research")

sources: List[str] = Field(description="Sources of information")

# Define an atomic agent component

class ResearchAgent:

def __init__(self, api_key: str):

self.api_key = api_key

# Initialize any necessary clients or tools

def process(self, input_data: ResearchQuery) -> ResearchResult:

# In a real implementation, this would use an LLM to perform research

print(f"Researching {input_data.topic} at depth {input_data.depth}")

# Simulate research results

findings = [

f"Finding 1 about {input_data.topic}",

f"Finding 2 about {input_data.topic}",

f"Finding 3 about {input_data.topic}"

]

sources = [

"https://github.com/e2b-dev/awesome-ai-agents",

"https://github.com/e2b-dev/awesome-ai-agents"

]

return ResearchResult(findings=findings, sources=sources)

# Usage example

if __name__ == "__main__":

# Create the agent

agent = ResearchAgent(api_key=os.environ.get("OPENAI_API_KEY", "default-key"))

# Create input data

query = ResearchQuery(topic="AI agent frameworks", depth=3)

# Process the query

result = agent.process(query)

# Display results

print("\nResearch Findings:")

for i, finding in enumerate(result.findings, 1):

print(f"{i}. {finding}")

print("\nSources:")

for source in result.sources:

print(f"- {source}")9、Rasa

RASA 是一个专注于构建会话式 AI 应用程序的开源机器学习框架,重点放在基于文本和语音的助手。

主要功能:

- 先进的自然语言理解(NLU)

- 灵活性和上下文感知对话代理的控制

- 机器学习能力,用于构建、测试和部署 AI 应用程序

优点:

- 高度可定制

- 强大的机器学习框架

- 全面的文档

- 支持复杂的对话场景

缺点:

- 相比无代码平台需要更多技术专业知识

- 初学者的学习曲线更陡峭

- 可能需要显著的开发资源

使用案例:

- 聊天机器人开发

- 虚拟助手

- 客户服务界面

- 基于语音的交互系统

- 企业对话式 AI 解决方案

代码示例:

# RASA project structure example

# This would typically be spread across multiple files in a RASA project

# domain.yml - Defines the domain of the assistant

"""

version: "3.1"

intents:

- greet

- goodbye

- ask_about_ai_frameworks

responses:

utter_greet:

- text: "Hello! How can I help you with AI frameworks today?"

utter_goodbye:

- text: "Goodbye! Feel free to ask about AI frameworks anytime."

utter_about_frameworks:

- text: "There are several popular AI agent frameworks including LangChain, AutoGen, CrewAI, and more. Which one would you like to know about?"

entities:

- framework_name

slots:

framework_name:

type: text

mappings:

- type: from_entity

entity: framework_name

"""

# data/nlu.yml - Training data for NLU

"""

version: "3.1"

nlu:

- intent: greet

examples: |

- hey

- hello

- hi

- hello there

- good morning

- intent: goodbye

examples: |

- bye

- goodbye

- see you around

- see you later

- intent: ask_about_ai_frameworks

examples: |

- tell me about AI frameworks

- what are the best AI agent frameworks

- I need information about [LangChain](framework_name)

- How does [AutoGen](framework_name) work?

- Can you explain [CrewAI](framework_name)?

"""

# data/stories.yml - Training data for dialogue management

"""

version: "3.1"

stories:

- story: greet and ask about frameworks

steps:

- intent: greet

- action: utter_greet

- intent: ask_about_ai_frameworks

- action: utter_about_frameworks

- story: ask about specific framework

steps:

- intent: ask_about_ai_frameworks

entities:

- framework_name: "LangChain"

- action: action_framework_info

"""

# actions/actions.py - Custom actions

"""

from typing import Any, Text, Dict, List

from rasa_sdk import Action, Tracker

from rasa_sdk.executor import CollectingDispatcher

class ActionFrameworkInfo(Action):

def name(self) -> Text:

return "action_framework_info"

def run(self, dispatcher: CollectingDispatcher,

tracker: Tracker,

domain: Dict[Text, Any]) -> List[Dict[Text, Any]]:

framework = tracker.get_slot("framework_name")

if framework.lower() == "langchain":

dispatcher.utter_message(text="LangChain is an open-source framework for building applications using large language models.")

elif framework.lower() == "autogen":

dispatcher.utter_message(text="AutoGen is a framework from Microsoft Research that enables the development of LLM applications using multiple agents.")

elif framework.lower() == "crewai":

dispatcher.utter_message(text="CrewAI is a framework for orchestrating role-playing autonomous AI agents.")

else:

dispatcher.utter_message(text=f"I don't have specific information about {framework}, but it might be one of the emerging AI agent frameworks.")

return []

"""

# To train and run a RASA assistant:

# rasa train

# rasa run10、MetaGPT

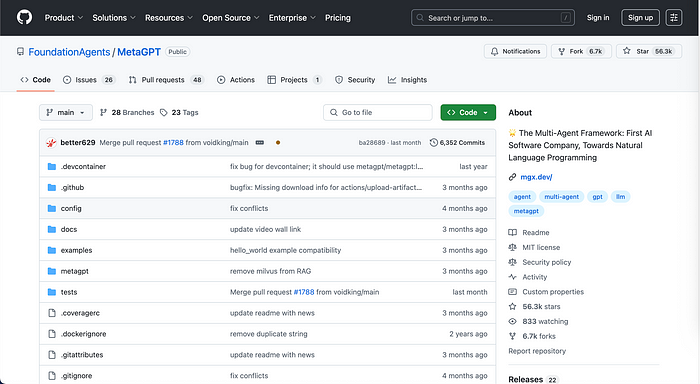

由 Chenglin Wu 创立,MetaGPT 是最受欢迎的开源代理框架之一

MetaGPT 是一个开源的多代理框架,使用 LLMs 协调 AI 代理以模拟协作问题解决。由 Chenglin Wu 创立,MetaGPT 在其 GitHub 仓库上有超过 56K 星,展示了开发人员对该开源代理框架的喜爱,因为它具有灵活性和易于使用的特性。

主要功能:

- 可以从单一需求行生成全面的项目材料

- 模拟软件开发团队结构

- 为代理分配不同的 GPT 角色

- 支持复杂的协作问题解决

优点:

- 模拟人类程序性知识

- 优化多代理系统交互

- 自动化全面的软件开发工作流

- 可以模拟整个团队角色

缺点:

- 设置复杂

- 依赖于大型语言模型的能力

- 多代理交互可能存在不一致性

使用案例:

- 自动化软件开发项目生成

- 复杂的多代理协作问题解决

- 高级 AI 驱动的研究和分析

- 模拟组织决策过程

代码示例:

from metagpt.roles import (

ProjectManager,

ProductManager,

Architect,

Engineer

)

from metagpt.team import Team

import asyncio

async def main():

# Define the project requirement

requirement = "Create a web application that allows users to search for and compare AI agent frameworks"

# Create team members with different roles

product_manager = ProductManager()

project_manager = ProjectManager()

architect = Architect()

engineer = Engineer()

# Form a team with these roles

team = Team(

name="AI Framework Explorer Team",

members=[product_manager, project_manager, architect, engineer]

)

# Start the team working on the requirement

await team.run(requirement)

# The team will generate:

# 1. PRD (Product Requirements Document)

# 2. Design documents

# 3. Architecture diagrams

# 4. Implementation code

# 5. Tests

if __name__ == "__main__":

asyncio.run(main())

11、Camel-AI (CAMEL)

Camel-AI (CAMEL — Communicative Agents for Machine Learning) 是一个开源的多代理框架,使自主代理能够协作、沟通并解决复杂任务。

主要功能:

多代理协作

- 支持持续演进的代理系统

- 通用的多代理应用程序基础设施

- 整合文本和图像任务的 AI 模型

优点:

- 开源

- 灵活的框架

- 支持各种 AI 模型集成

- 支持自主代理通信

缺点:

- 作为一个较新的框架,其文档和功能可能仍在发展中

使用案例:

- 自主任务解决

- 数据生成和分析

- 模拟环境

- 复杂计算问题解决

代码示例:

from camel.agents import ChatAgent

from camel.messages import BaseMessage

from camel.typing import ModelType

import asyncio

async def main():

# Create two agents with different roles

user_agent = ChatAgent(

model_type=ModelType.GPT_4,

system_message="You are a user who needs help analyzing data about AI frameworks."

)

assistant_agent = ChatAgent(

model_type=ModelType.GPT_4,

system_message="You are an AI assistant specialized in data analysis and AI frameworks."

)

# Initial message from the user agent

user_message = BaseMessage.make_user_message(

role_name="User",

content="I need to compare different AI agent frameworks for my project. Can you help me analyze their features?"

)

# Start the conversation

assistant_response = await assistant_agent.step(user_message)

print(f"Assistant: {assistant_response.content}\n")

# Continue the conversation

for _ in range(3): # Simulate a few turns of conversation

user_response = await user_agent.step(assistant_response)

print(f"User: {user_response.content}\n")

assistant_response = await assistant_agent.step(user_response)

print(f"Assistant: {assistant_response.content}\n")

if __name__ == "__main__":

asyncio.run(main())12、结束语

人工智能代理框架领域正在迅速发展,开源解决方案在创新和灵活性方面处于领先地位。对于希望构建复杂人工智能应用程序的开发人员来说,这些框架提供了构建智能、自主系统的工具和基础设施。

无论您需要构建会话代理、多代理协作系统还是复杂的流程自动化,本指南涵盖的11个框架提供了范围广泛的选项,以满足不同的需求和技术熟练程度。

随着人工智能代理技术的不断发展,保持对这些框架的功能和局限性的了解将是开发人员利用其应用程序中人工智能全部潜力的关键。

原文链接:11 Best AI Agent Frameworks for Software Developers

汇智网翻译整理,转载请标明出处