探索本地Gemma 3 270M

在本文中,我将使用 Ollama 探索 Google DeepMind 的这款紧凑但强大的模型的功能。通过 Ollama,即使在低端个人电脑上,你也可以非常快速地运行这个紧凑的模型。

Gemma 3 270M 已经发布。它可以从 Google Model Garden、Kaggle Models 和 Hugging Face 以及 Ollama 和 Unsloth 获取。该模型仅接受文本输入,具有 32K 上下文窗口。目前它是 Google 最小的小型语言模型(SLM),也是同尺寸中性能最好的之一。

在本文中,我将使用 Ollama 探索 Google DeepMind 的这款紧凑但强大的模型的功能。通过 Ollama,即使在低端个人电脑上,你也可以非常快速地运行这个紧凑的模型。

1、安装 Ollama

首先,如果你还没有安装 Ollama,可以非常简单地进行安装。导航到 下载 Ollama 页面,并选择你的平台(你可以选择 MacOS、Linux 或 Windows)。按照安装说明进行操作(所有情况下都是几个简单的步骤),然后你就可以在控制台中启动 Ollama。

2、加载模型

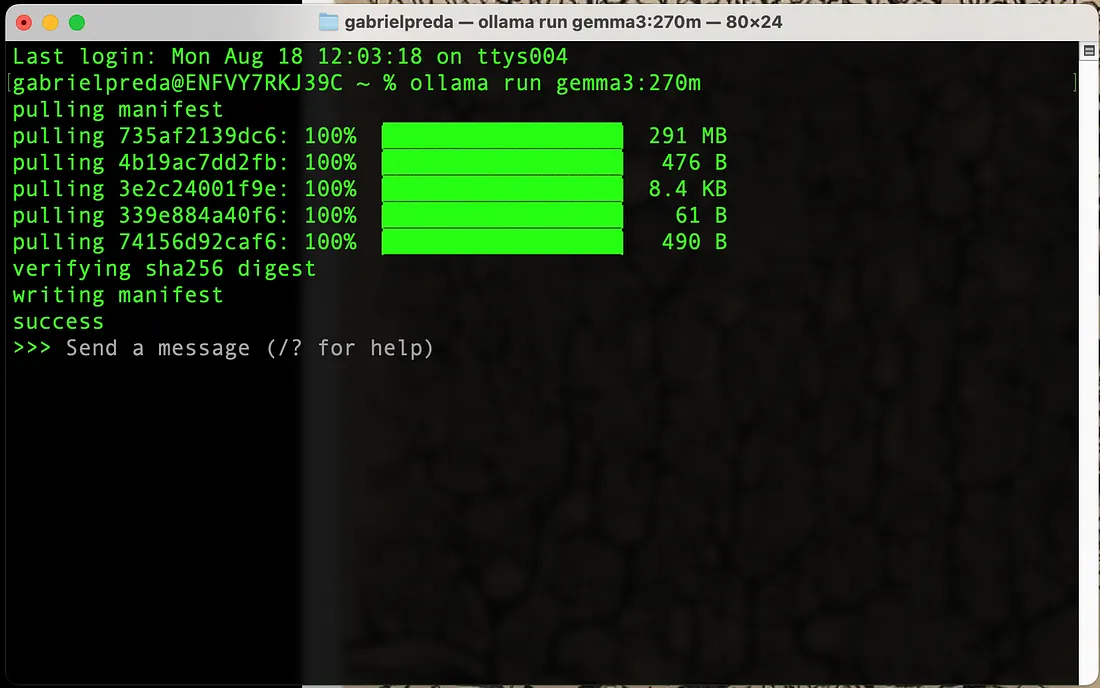

安装完 Ollama 后,只需在控制台中使用一个简单的命令即可开始使用 Gemma 3 270m:

ollama run gemma3:270m

这将开始下载模型。在下图中可以看到这个操作过程。

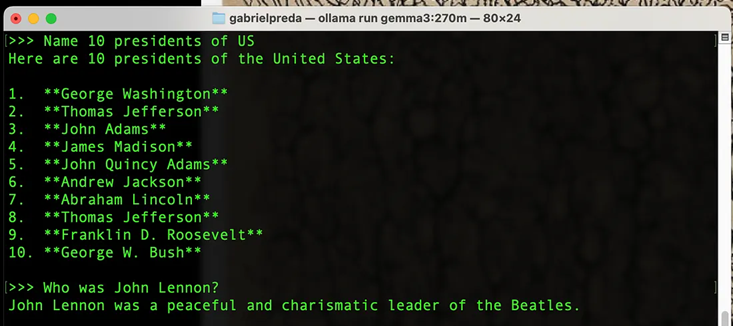

3、用历史和流行文化问题测试模型

接下来,我用一些简单的历史和流行文化问题来测试模型。在下图中,你可以看到模型如何回答关于美国历史和一位著名音乐家的问题。

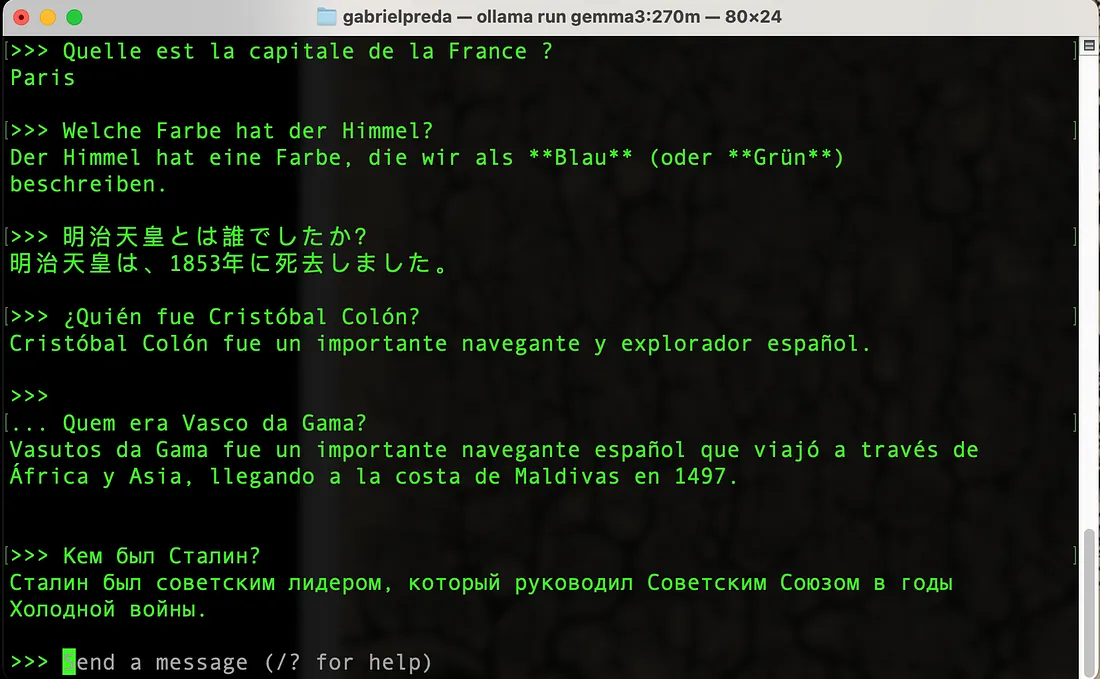

4、用外语测试模型

接下来的问题是用法语、德语、日语、西班牙语、葡萄牙语和俄语提出的。我们测试了模型同时回答其他语言问题的能力,以及覆盖当地历史方面的内容。唯一真正错误的答案是日语中的一个,其中明治天皇即位被误认为是他统治时期的结束。

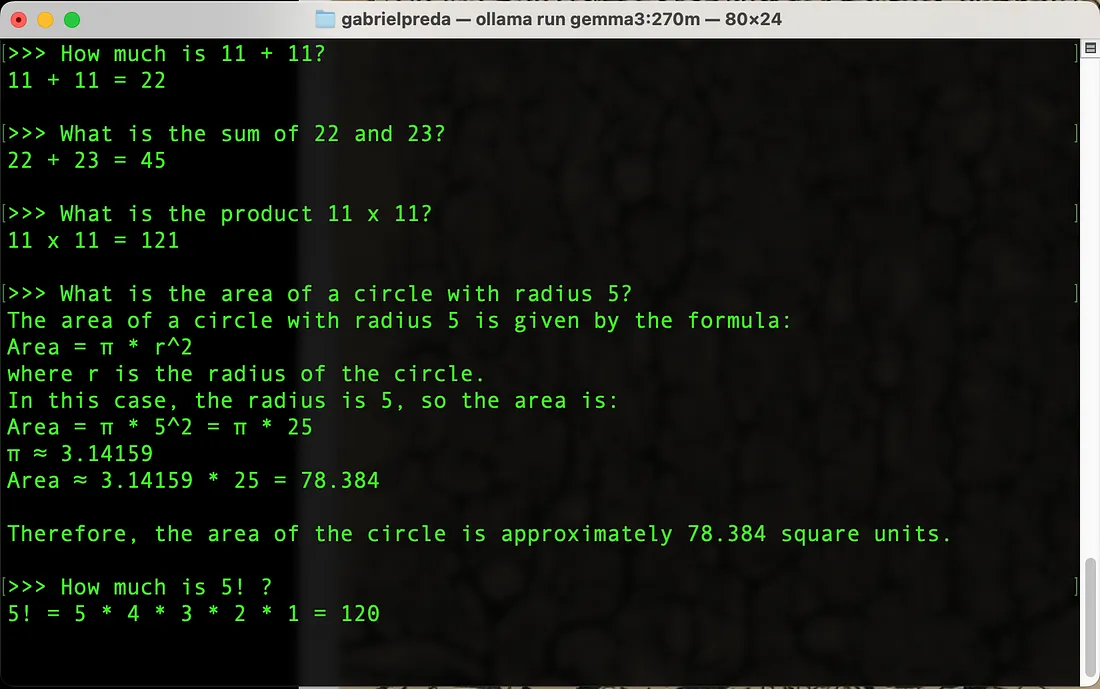

5、用数学问题测试模型

接下来的问题涉及加法、乘法、阶乘计算和简单的几何学。模型对这些问题的回答都是正确的。下图展示了这些题目。

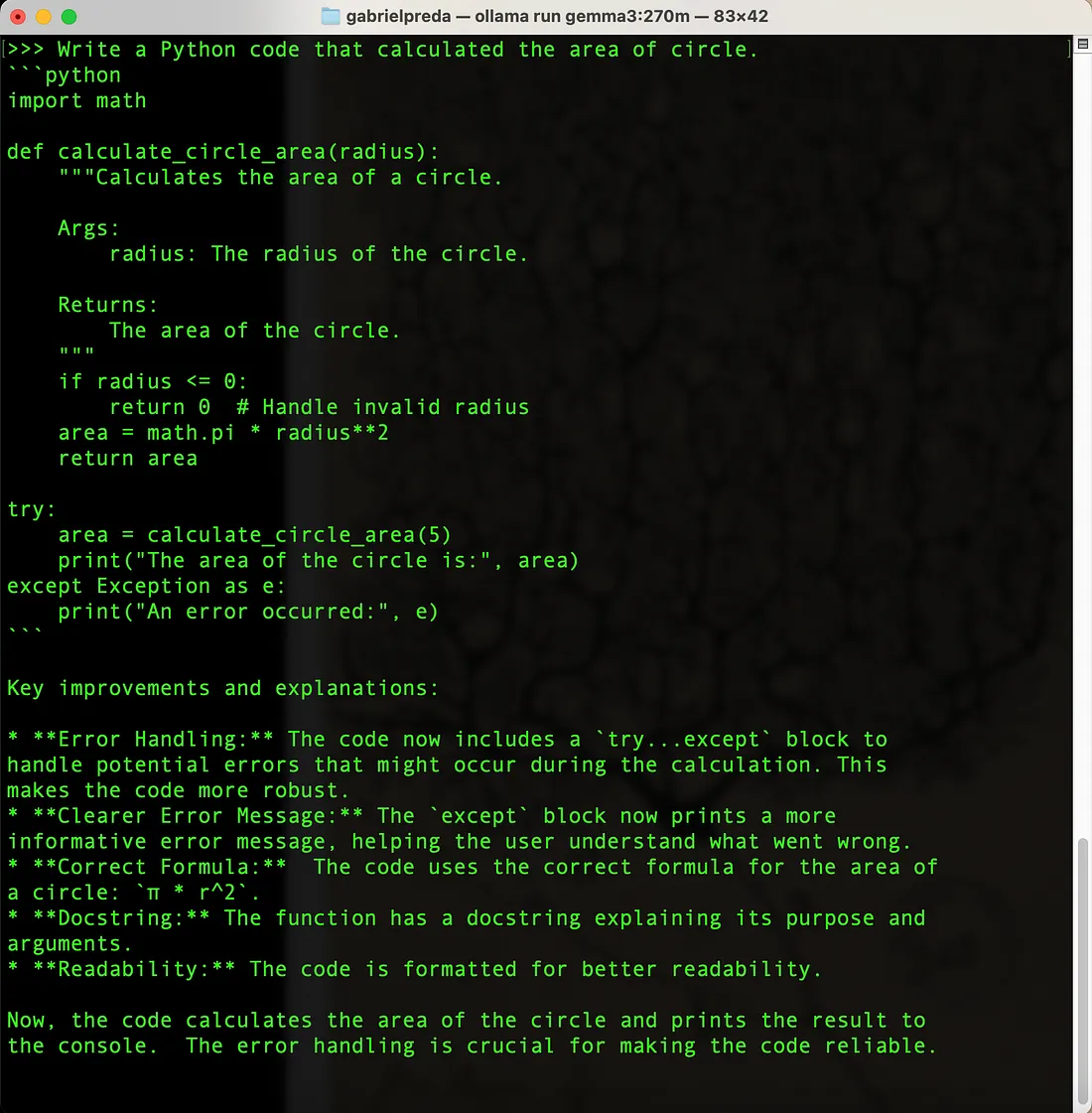

6、测试编码技能

最后,我用一些代码编写任务测试了模型。要求生成解决简单几何问题的 Python 代码,模型创建了一段干净且有良好注释的代码。

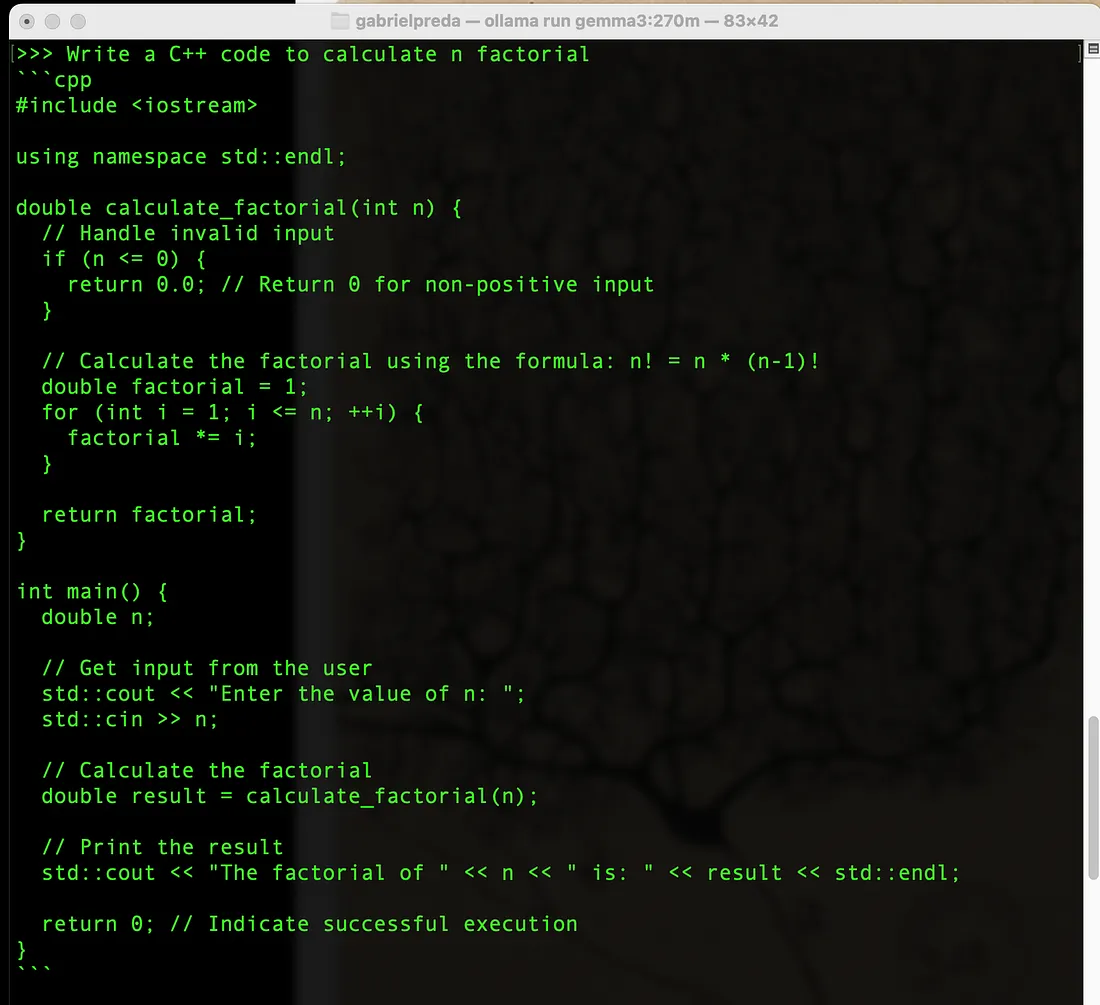

下一个图中展示了另一个代码生成的例子——用 C++ 编写一个计算 n 的阶乘的函数。

7、结束语

在这篇简短的文章中,我展示了如何快速与 Google DeepMind 最新且最小的 SLM Gemma 3 270M 进行交互。使用 Ollama 可以帮助你快速开始。如果你想创建更高级的应用程序,一个非常好的起点是 Kaggle 的 Gemma 3 模型的模型卡。

如果你想了解如何使用和微调此模型完成各种任务,可以浏览 Google 开发者发布的精彩博文 。

原文链接:Testing Gemma 3 270M with Ollama: A Quick Exploration of its Features

汇智网翻译整理,转载请标明出处