Kimi K2 Thinking

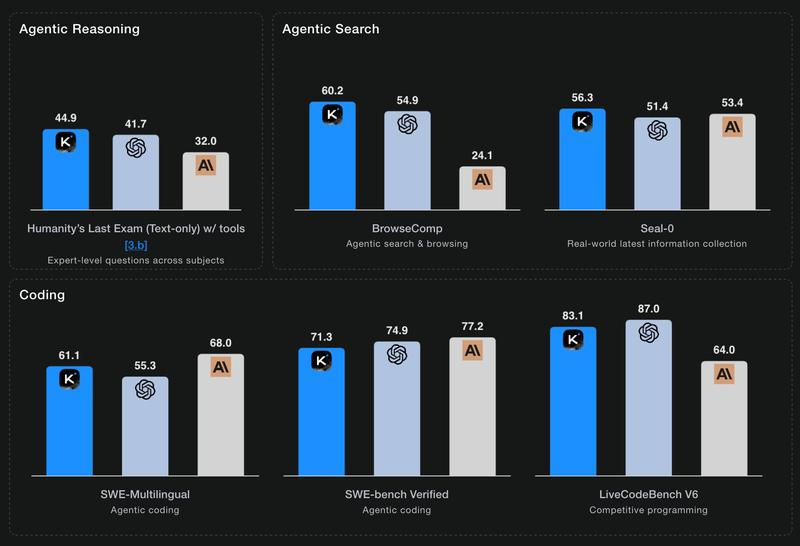

Moonshot AI 的基准测试成绩,显示 K2 Thinking 在“代理推理”和“代理搜索”方面击败了顶级的 OpenAI 和 Anthropic 模型,但在“编码”方面并未达到顶尖水平。

Moonshot 的 Kimi K2 被确立为最大的开源权重模型之一,拥有 1 万亿参数——早在七月。他们现在发布了 Thinking 版本,同样是 1 万亿参数(MoE,32B 活动),并且在他们自定义修改的(因此并不完全开源)MIT 许可证下。

从 Kimi K2 开始,我们将其构建为一个逐步推理并动态调用工具的思考代理。它通过大幅扩展多步骤推理深度并在 200-300 次连续调用中保持稳定的工具使用,在 Humanity's Last Exam (HLE)、BrowseComp 和其他基准测试中设定了新的最先进水平。同时,K2 Thinking 是一个原生 INT4 量化模型,具有 256k 上下文窗口,实现了推理延迟和 GPU 内存使用的无损减少。

这个模型在 Hugging Face 上只有 594GB——Kimi K2 是 1.03TB——我认为这是由于新的 INT4 量化。这使得模型在托管时更加便宜且快速。

到目前为止,唯一托管它的只有 Moonshot 自己。我通过 他们自己的 API 和 OpenRouter 代理 测试了它,分别通过 llm-moonshot 插件(由 NickMystic 编写)和我的 llm-openrouter 插件。

目前围绕这个模型的反响非常积极。这是否可能是第一个能够与 OpenAI 和 Anthropic 最新模型竞争的开源权重模型,特别是对于长时间运行的代理工具调用序列?

Moonshot AI 的 自我报告的基准测试成绩 显示 K2 Thinking 在“代理推理”和“代理搜索”方面击败了顶级的 OpenAI 和 Anthropic 模型(GPT-5 和 Sonnet 4.5 Thinking),但在“编码”方面并未达到顶尖水平:

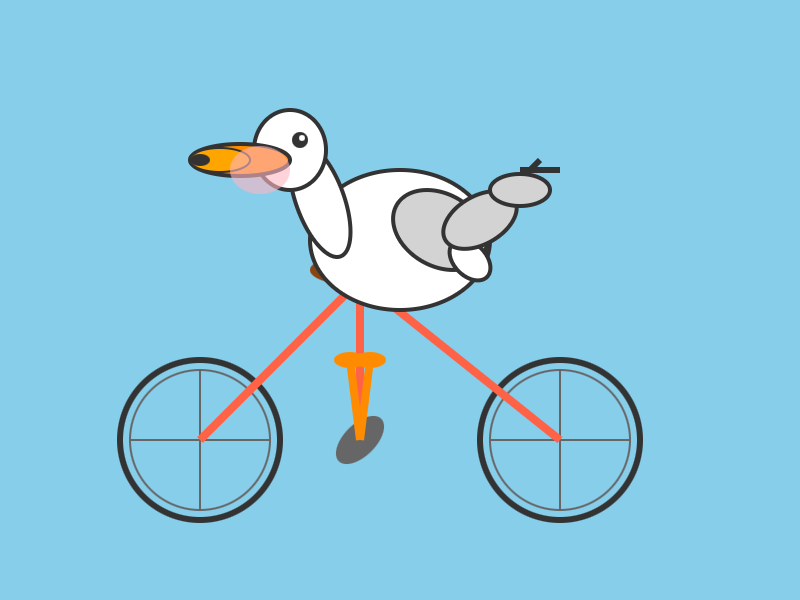

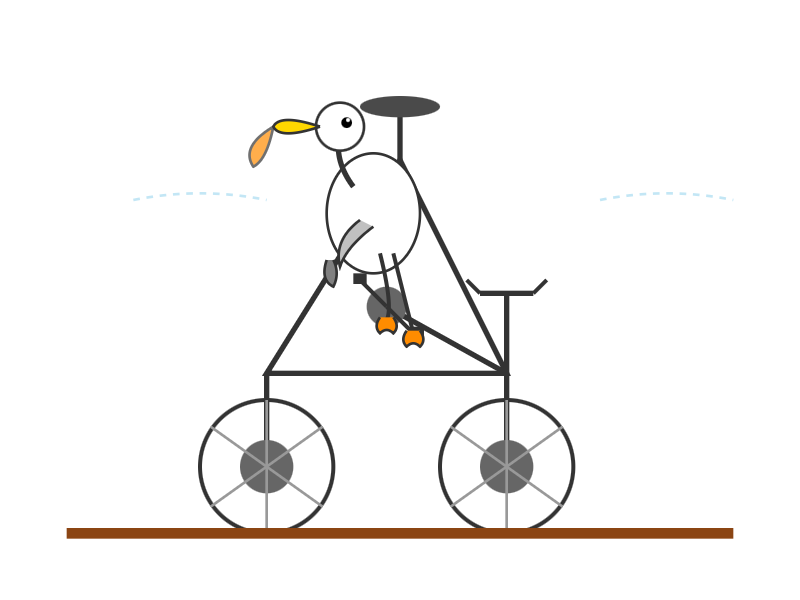

我运行了一些 pelican 测试:

llm install llm-moonshot

llm keys set moonshot # 粘贴密钥

llm -m moonshot/kimi-k2-thinking '生成一个鹈鹕骑自行车的 SVG'

llm install llm-openrouter

llm keys set openrouter # 粘贴密钥

llm -m openrouter/moonshotai/kimi-k2-thinking '生成一个鹈鹕骑自行车的 SVG'

Artificial Analysis 表示:

Kimi K2 Thinking 在 𝜏²-Bench Telecom 基准测试中达到了 93%,这是一个代理工具使用基准测试,模型充当客户服务代理。这是我们在独立测量中获得的最高分数。在长期代理上下文中使用工具是 Kimi K2 Instruct 的优势,而这种新的 Thinking 变体似乎取得了显著进步。

CNBC 引用了提供训练价格的来源 提供了该模型的训练价格:

据熟悉此事的消息人士称,Kimi K2 Thinking 模型的训练成本为 460 万美元。 [...] CNBC 无法独立验证 DeepSeek 或 Kimi 的数据。

MLX 开发者 Awni Hannun 成功在两个 512GB 的 M3 Ultra Mac Studio 上运行:

新的 1 万亿参数 Kimi K2 Thinking 模型在两个 M3 Ultras 上以原生格式运行良好——没有质量损失! 该模型是在 int4 下进行量化感知训练(qat)。 在 mlx-lm 中使用管道并行性,它生成了约 3500 个标记,速率为 15 个标记/秒。

原文链接:Kimi K2 Thinking - Simon Willison's Weblog

汇智网翻译整理,转载请标明出处