MAKER:不会出错的AI系统

即使是最好的AI,在长期项目上也表现得很糟糕。MAKER提供了一个完全不同的解决方案。

当世界上最好的AI模型在运行几百步后就崩溃时,一个新系统展示了如何实现完美的长期推理。以下是它的工作原理。

你有没有试过让AI完成一些非常复杂且耗时的任务?

也许你让它写一本20章的小说,或者制定一份包含上百个环节的详细商业计划。通常会发生什么呢?

一开始它表现出色,但过了一段时间后,它就……崩溃了。它开始感到困惑,忘记指令,并开始犯一些莫名其妙的错误。

嗯……

事实证明,这并非你独有的现象。即使是最强大的大型语言模型(LLM),也存在一个根本性的弱点。它们存在“持续错误率”,即在任何步骤中都有极小的出错概率。

错误率可能是1%,听起来很不错,对吧?99%的准确率!

但是,如果你的任务有100个步骤,那么这1%的失败概率就会累积起来。100个步骤之后,所有步骤都正确的概率几乎为零。整个过程注定会崩溃。

嗯……好吧。所以即使是最好的AI,在长期项目上也表现得很糟糕?没错。这是人工智能领域的一个小秘密。

但如果解决方案不是构建一个错误率仅为 0.00001% 的“更智能”的人工智能呢?如果存在一种完全不同的方法来解决这个问题呢?

一篇题为《零误差解决百万步 LLM 任务》的新研究论文向我们展示了这种方法。说实话,这是我很久以来见过的最巧妙的成果之一。

1、重大问题:为什么AI无法进行长期思考

首先,让我们真正理解这个问题。

研究人员使用了一种名为“汉诺塔”的经典谜题来测试现代 LLM 的极限。这是一个由圆盘和木桩组成的简单游戏,但随着圆盘数量的增加,解决它所需的步数呈指数级增长。

- 使用 10 个圆盘时,大约需要 1000 步。

- 用 20 个圆盘,需要超过一百万步。

当他们让最好的逻辑线性模型(LLM)来解决这个问题时,这些模型惨败。它们可以处理几个圆盘,但几百步之后,它们必然会犯错,整个解决方案也会因此而失败。

这证明,即使AI能够规划任务,在执行过程中也常常会失败。

这就像一位才华横溢的建筑师,他能设计一座摩天大楼,却连一块砖都放不直。最终,整栋楼都会坍塌。

2、天才的想法:将智能分解成百万个碎片

那么,研究人员是如何解决这个问题的呢?

他们并没有试图构建一个更强大的大脑,而是构建了一个更强大的系统。这个想法被称为大规模分解智能体过程(MDAP)。

这听起来很复杂,但这个想法的精妙之处在于它的简洁。

与其让一个超级智能的AI去解决一个百万步难题,不如把这个问题分解成一百万个极其简单、只需一步就能解决的小问题。

再把每个小问题分配给一个独立的、简单的AI代理呢?

想象一下造车。你不会让一个技艺精湛的工匠从零开始造出一整辆车。你会有一条装配线。一个人装上轮子,另一个人拧上螺丝,还有一个人连接电线。每一步都微不足道,但当它们串联起来,就能造出一辆功能齐全的汽车。

这正是名为MAKER的全新系统在人工智能任务中所做的。

3、MAKER:不会犯错的AI系统

MAKER并非一个独立的AI。它是一个框架,一套规则,让众多简单的AI代理能够完美协作。它包含三个核心组件。

3.1 最大分解

首先,MAKER 将庞大的问题分解成尽可能小的单元。以汉诺塔问题为例,这意味着每个智能体的任务不再是“解决整个问题”,而是“给定当前棋盘状态,下一步该怎么走?”

仅此而已。一步,不多不少。这使得每个智能体都高度专注于一个极其简单的任务。

3.2 领先 K 步投票制

但是,如果这些简单的智能体中仍然有人犯了错误呢?

这就是神奇之处。对于每一个微小的步骤,MAKER 不会只询问一个 AI 智能体,而是同时询问一组智能体。

假设它询问了 10 个智能体下一步该怎么走。

- 其中 7 个智能体给出的答案是“将圆盘 1 从 A 柱移动到 B 柱”。

- 其中两人说“将圆盘 2 从 C 柱移到 A 柱”。

- 另一人说一些完全随机的内容。

系统会等待,直到某个答案的得票数超过其他所有答案的一定数量(这就是“领先 k”的部分)。例如,它系统可能会等到某个答案的得票数比其他答案多出 3 票。该答案将被宣布为获胜答案,系统进入下一步。

想象一下,在游戏节目中询问观众。虽然个别观众可能会犯错,但群体智慧几乎总是正确的。这种投票系统就像一个纠错机制,使整个系统如此可靠。

3.3 标记可疑答案

还有最后一块拼图。如果人工智能代理状态不佳,给出了一个非常奇怪的答案怎么办?也许答案太长,或者格式完全错误。

MAKER 有一条简单的规则:如果答案看起来可疑,就会被“标记”并丢弃。系统会从另一个代理那里获得另一张选票。

哈哈,这就像夜店的保安。如果你不遵守规则,就进不去。这种简单的质量检查可以过滤掉最明显的错误,使投票过程更加稳健。

4、百万步挑战

那么,它有效吗?

研究人员让 MAKER 解决包含 20 个圆盘的汉诺塔问题,这项任务需要 1,048,575 步。

结果如何?它完美地解决了整个问题,而且零错误。

哇……真是令人惊叹。

但最令人震惊的是,为了实现这一点,他们甚至没有使用顶级的“推理”模型。他们使用的是 gpt-4.1-mini,一个更便宜、性能更低的模型。

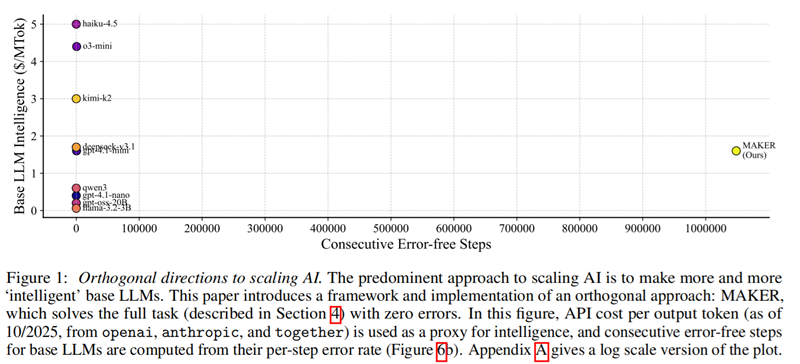

看看论文中的这张图表:

y 轴代表“基础 LLM 智能”,它基本上反映了模型的成本(以及所谓的智能程度)。x 轴代表“连续无错误步数”,也就是模型在崩溃前可以运行的时间。

你看到所有其他模型,即使是最先进的模型,都聚集在左下角吗?它们最多只能运行几百步。

然后你会看到 MAKER,它位于最右侧,超过了一百万步。

这张图表表明,我们一直在朝着错误的方向扩展人工智能。我们一直在试图攀登更高的山峰(构建更智能的模型),而我们本可以只建造一座桥梁(一个更好的系统)。

5、为什么这改变了一切

这项研究不仅仅是一个很酷的实验。它标志着我们应该如何思考构建强大的人工智能系统这一问题的重大转变。

- 可靠性胜于原始智能:人工智能的未来可能并非单一的、如同神一般的通用人工智能(AGI)。它可能是由数百万个简单但略有不可靠性的组件构建而成的极其复杂且可靠的系统。这是一种我们用于建造桥梁和计算机的工程原理,现在被应用于人工智能推理。

- 它更经济:你无需花费巨资购买市面上最先进的人工智能模型。借助像 MAKER 这样的系统,你可以使用更便宜、更高效的模型,在长期任务中获得远超预期的结果。这具有巨大的经济意义。

- 这是通往更安全人工智能之路:说实话,一个单一的、超级智能的黑箱人工智能确实有点可怕。它难以控制、难以审计、也难以理解。但是,一个由一百万个简单智能体组成的系统呢?每个智能体都承担着一项明确定义的任务。这样就更容易监控、调试和控制。这种“蚁群”式的方法本质上更安全。

当然,这种方法也有其局限性。它最适合那些可以轻松分解成一系列步骤的问题。它可能不适用于那些需要整体性、创造性思维才能完成的任务。但是,对于科学、物流、软件开发等领域的众多任务来说,这无疑是一项颠覆性的变革。

6、未来是蚁群,而非单一的巨人

多年来,人工智能领域的竞赛一直围绕着构建越来越大的模型。但本文表明,我们可能一直找错了方向。

人工智能的下一个重大飞跃或许并非来自更强大的大脑,而是来自更完善的蓝图。

它预示着一个未来:我们不再依赖单一的、卓越的人工智能来解决所有问题。相反,我们将构建庞大的、去中心化的微智能体系统,这些微智能体能够以近乎完美的可靠性协同工作。这并非指一个庞然大物,而是指一支协调运作的“蚂蚁大军”。

所以,或许真正的问题不是“我们如何让人工智能更智能?”

而是:

“我们如何构建能够充分利用我们已有智能的系统?”

原文链接:A Million AI Agents Just Ran a 1,000,000-Step Task Without a Single Error

汇智网翻译整理,转载请标明出处