用Ollama Launch连接AI编码代理

忘记配置烦恼,Ollama launch 是启动 Claude Code、Codex、Opencode、Moltbot 或任何其他 CLI 工具的新方法。

Ollama v0.15 引入了一个名为 ollama launch 的新命令,用于设置和运行你喜欢的编码工具,如 Claude Code、OpenCode 和 Codex,支持本地或云端模型。

如果你一直在关注 Ollama 的最新更新,你知道他们在 v0.14 中添加了 Anthropic API 兼容性。

这为 Claude Code 等工具与开源模型配合使用打开了大门。

但设置仍需要手动配置,包括导出环境变量、设置基础 URL 以及弄清楚哪些模型适合编码。

ollama launch 命令改变了这一点,使启动变得更好。

我想测试一下并与你分享我的发现,因为我知道你们中的许多人正在寻找在本地运行代理编码工具而不用消耗 API 积分的方法。

所以我花了一个下午设置不同的集成,测试各种模型,并记录哪些有效。

在这篇文章中,让我向你展示我发现的关于 Ollama Launch 的内容。

1、Ollama Launch 是什么?

ollama launch 是一个新命令,它处理将编码工具连接到 Ollama 模型的所有设置。

它会引导你完成模型选择并自动启动你选择的集成。

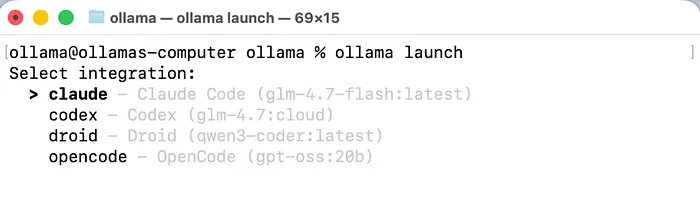

目前,它支持四个集成:

- Claude Code — Anthropic 的代理编码工具,运行在你的终端中

- OpenCode — 终端编码的开源替代方案

- Codex — OpenAI 的编码助手集成

- Droid — 另一个编码工具选项

当你运行 ollama launch 时,会看到一个交互式菜单来选择你想要的集成。

或者你可以使用 ollama launch claude 或 ollama launch opencode 等命令直接转到特定工具。

设置在后台处理 Anthropic API 配置。以前,你需要手动设置:

export ANTHROPIC_AUTH_TOKEN=ollama

export ANTHROPIC_BASE_URL=http://localhost:11434

现在只需运行一个命令,你就准备好编码了。

2、开始使用

设置大约需要五分钟。这是你需要做的。

2.1 更新 Ollama

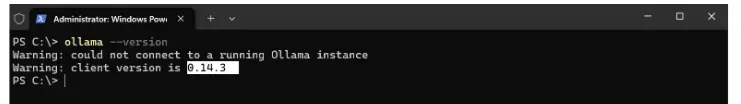

确保你有 Ollama v0.15 或更高版本。如果你使用的是旧版本,请从 ollama.com 下载最新版本。

确保安装了 Ollama v0.15+

- 检查版本:

ollama --version

我的当前版本落后了,所以我需要运行更新。

如果需要,从以下地址更新:https://ollama.com/download。下载完成后,点击它开始升级,并按照向导步骤完成。安装完成后,确认版本应该是 0.15.2 或更高。

2.2 拉取编码模型

你需要一个能很好处理代码的模型。Ollama 推荐这些:

对于本地模型(需要约 23GB VRAM,支持 64K 上下文):

glm-4.7-flashqwen3-codergpt-oss:20b

对于云端模型(完整上下文长度,无硬件要求):

glm-4.7:cloudminimax-m2.1:cloudqwen3-coder:480b-cloud

拉取你选择的模型:

ollama pull glm-4.7-flash

或者对于云端:

ollama pull glm-4.7:cloud

预期输出:模型下载/注册(云端模型很轻量,因为推理在远程进行)

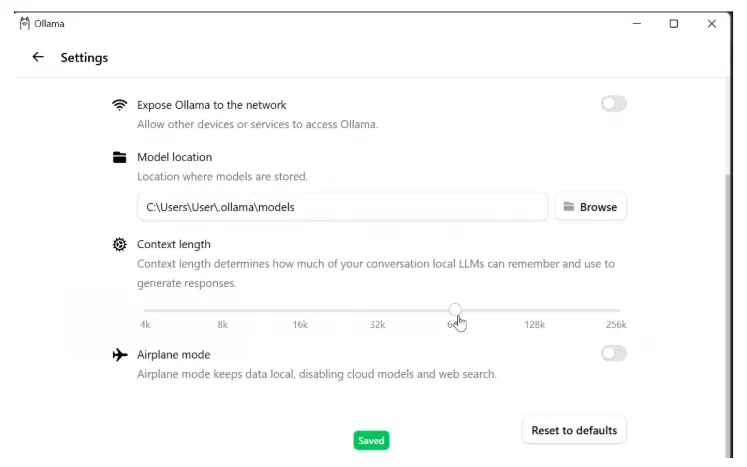

2.3 配置上下文长度

这很重要且容易遗漏。

默认情况下,Ollama 将上下文长度设置为 4,096 个令牌。

编码工具需要更多才能正常工作。你至少需要 64,000 个令牌才能用于 Claude Code 和类似工具。

打开 Ollama 设置并更新上下文长度。

如果没有此更改,模型将没有足够的内存来处理多文件操作、工具调用或扩展的编码会话。

云端模型自动以完整上下文长度运行,所以如果你使用那些,可以跳过此步骤。

2.4 启动

ollama launch claude

你会看到 Claude Code 使用你选择的模型启动。

请记住,在之前的步骤中,我拉取了 GLM-4.7 云端版本

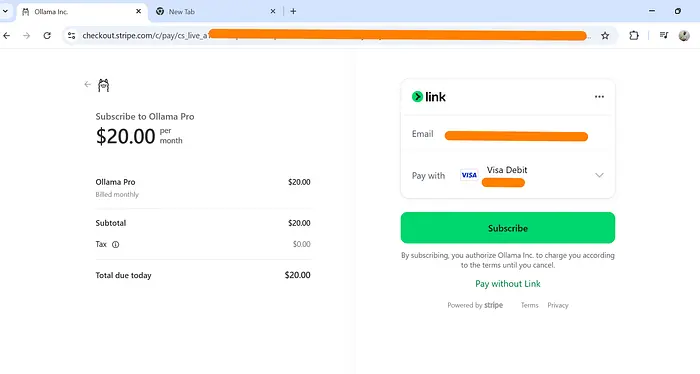

对于这一步,要工作,你需要确保你有 Ollama Cloud 账户,这每月花费我 20 美元,我在之前的教程中注册了 — 我尝试了 Claude Code Ollama 工作流程

如果你想拉取其他模型,这里是命令:

# GLM 4.7 Cloud — 推荐用于编码

ollama pull glm-4.7:cloud

# MiniMax M2.1 Cloud — 替代选项

ollama pull minimax-m2.1:cloud

# Qwen3 Coder 480B Cloud — 最大的编码模型

ollama pull qwen3-coder:480b-cloud

# GPT-OSS 120B Cloud — 另一个大选项

ollama pull gpt-oss:120b-cloud

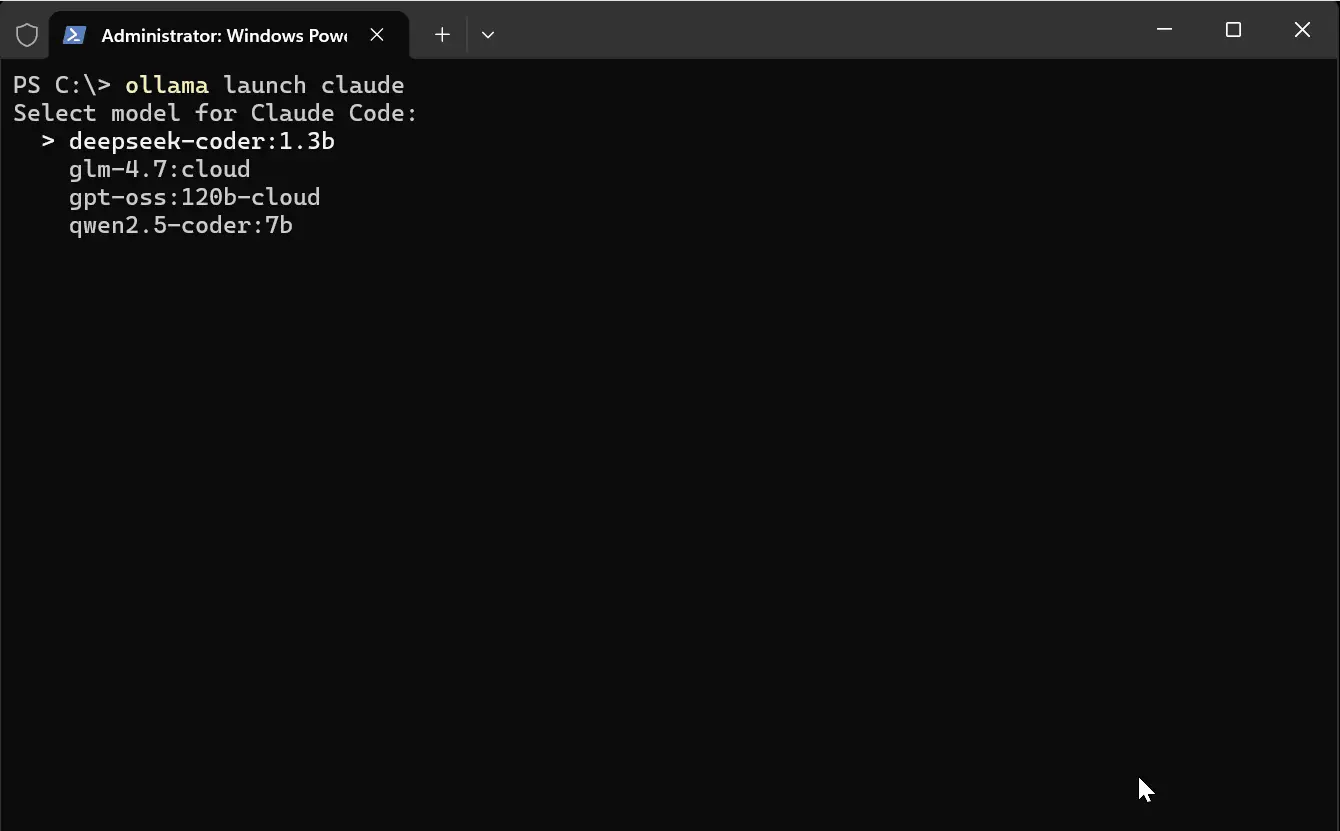

我之前还拉取了 gpt-oss:120b-cloud、deepseek-coder:1.3b 和 qwen2.5-coder:7b;这就是为什么你在我的可用模型列表中看到它们:

3、Ollama Launch 测试

我测试了 ollama launch 与 Claude Code 和 OpenCode

第一步是确保已安装 Claude Code

- macOS/Linux/WSL:

curl -fsSL https://claude.ai/install.sh | bash - Windows PowerShell:

irm https://claude.ai/install.ps1 | iex

你可能需要 Ollama 账户来使用云端模型

- 如果提示,在 ollama.com 注册

当你运行 ollama launch claude,你会看到一个模型选择提示。在我的情况下,我有一个本地和云端选项的混合:- deepseek-coder:1.3b (本地)*

- glm-4.7:cloud*

- gpt-oss:120b-cloud*

- qwen2.5-coder:7b (本地)

我为我的主要测试选择了 glm-4.7:cloud,因为云端模型以完整上下文长度运行,没有任何硬件限制。

一旦我选择模型选项,它就非常快速地启动了 Claude Code,而没有我在 之前的设置中遇到的配置麻烦

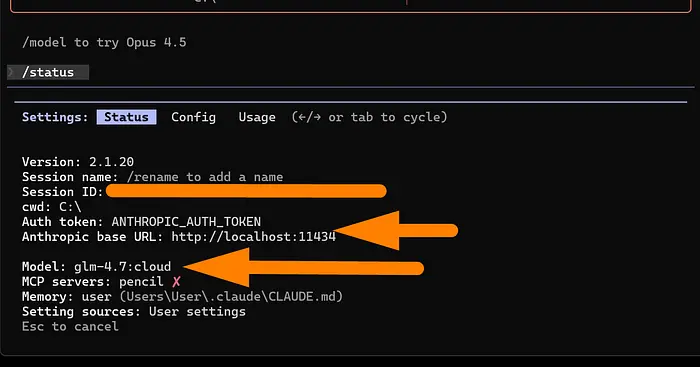

当我运行状态检查时,我看到环境变量如下:

- 模型:glm-4.7:cloud

- 认证令牌:ANTHROPIC_AUTH_TOKEN

- Anthropic 基础 URL:http://localhost:11434

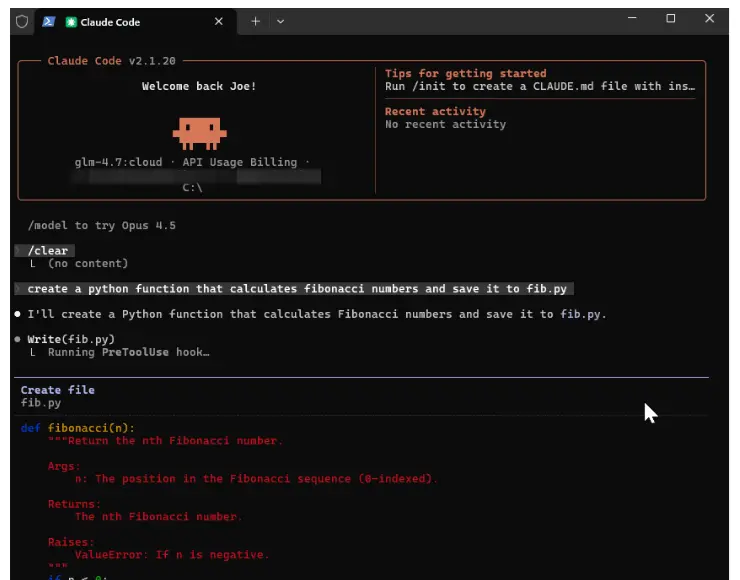

一旦 Claude Code 运行,我运行第一个提示来测试:

create a python function that calculates fibonacci numbers and save it to fib.py

正如你所见,它快速轻松地创建代码。 我 现在使用我的 Ollama Cloud 模型 + Claude Code 配合这个简单的 Ollama Launch 设置。

4、最后的想法

ollama launch 是 Ollama 工具包的最好补充,不再浪费时间在手动配置上。

它消除了设置编码工具集成的摩擦,并使整个过程对更多开发者开放。这一个命令让你从零开始使用本地模型运行 Claude Code。

Ollama 文档中提到了所有内容的链接。试一试,让我知道它对你的设置如何工作。

原文链接:I Tested (New) Ollama Launch For Claude Code, Codex, OpenCode & More

汇智网翻译整理,转载请标明出处