LFM2.5-1.2B-Thinking边缘模型

Liquid AI刚刚发布了一个12亿参数模型,生成思考痕迹,完全在设备上运行,并且可以匹敌3-5倍大小的模型。

AI编程/Vibe Coding 遇到问题需要帮助的,联系微信 ezpoda,免费咨询。

Liquid AI刚刚发布了一个12亿参数模型,生成思考痕迹,完全在设备上运行,并且可以匹敌3-5倍大小的模型。我终于通过LEAP SDK获得了LFM2.5-1.2B-Thinking。为了测试它的能力,我构建了一个个人助理应用程序,将其与FunctionGemma配对用于移动操作。结果:在三星S23上运行的真实推理,延迟低于1秒。

1、使LFM2.5-1.2B-Thinking与众不同的原因

这不仅仅是另一个小型语言模型。LFM2.5-1.2B-Thinking是一个专门为推理任务训练的12亿参数模型。它在产生答案之前生成思考痕迹,系统地解决问题。

与LFM2.5-1.2B-Instruct相比,Thinking变体的三个能力急剧提升:

- 数学推理:MATH-500上从63 → 88

- 指令遵循:Multi-IF上从61 → 69

- 工具使用:BFCLv3上从49 → 57

LFM2.5-1.2B-Thinking在大多数推理基准上匹配或超过Qwen3-1.7B,尽管参数少40%。此外,它需要更少的输出token,同时提供更高的整体性能——对于每个token都会产生延迟的边缘部署至关重要。

Liquid AI发现LFM2.5-1.2B-Thinking在推理繁重的任务中表现出色:

- 工具使用 — 规划工具调用序列

- 数学 — 多步数学推理

- 编程 — 代码生成和调试

- 代理任务 — 验证中间结果,调整方法

当模型需要规划、验证和调整时,推理痕迹提供真正的价值。

2、训练配方:构建思考模型

构建有能力的思考模型需要通过多步推理来增强有限的知识容量,同时为低延迟边缘部署保持简洁的答案。

推理模型的一个常见问题:陷入重复文本模式而不是得出结论。Liquid AI称之为"厄运循环"。

他们的解决方案:

- 在偏好对齐(DPO)期间:从SFT检查点生成5个温度采样和1个贪婪候选。选择的响应是在LLM判断下得分最高的;被拒绝的响应要么是得分最低的候选(当没有循环存在时),要么是任何循环候选,无论得分如何。

- 在RLVR期间:在训练早期应用基于n-gram的重复惩罚。

结果:厄运循环从15.74%下降到0.36% —— 40倍的减少。

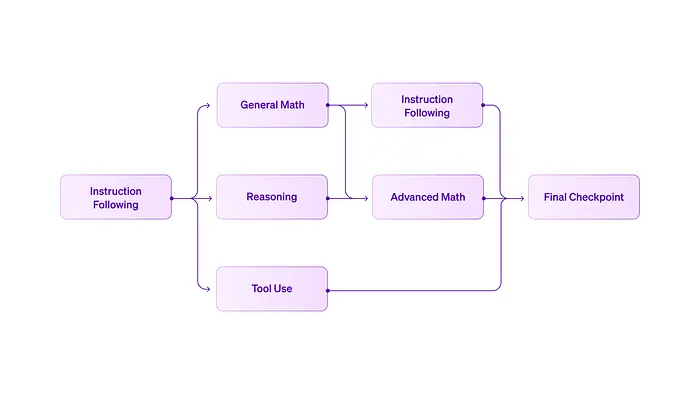

3、带有模型合并的课程学习

Liquid AI不是在所有领域同时训练单个模型,而是使用并行课程方法:

- 以指令遵循RLVR为基础开始

- 分支创建领域特定的检查点(推理、数学、工具使用)

- 合并检查点以组合能力

最终检查点是一个在其家谱中有25个独特检查点的合并模型。

这种方法对于小型、专注的团队也更有效。独立的工作流在自己的领域快速迭代而不会相互阻塞。通过合并而不是协调的联合训练运行来组合贡献。

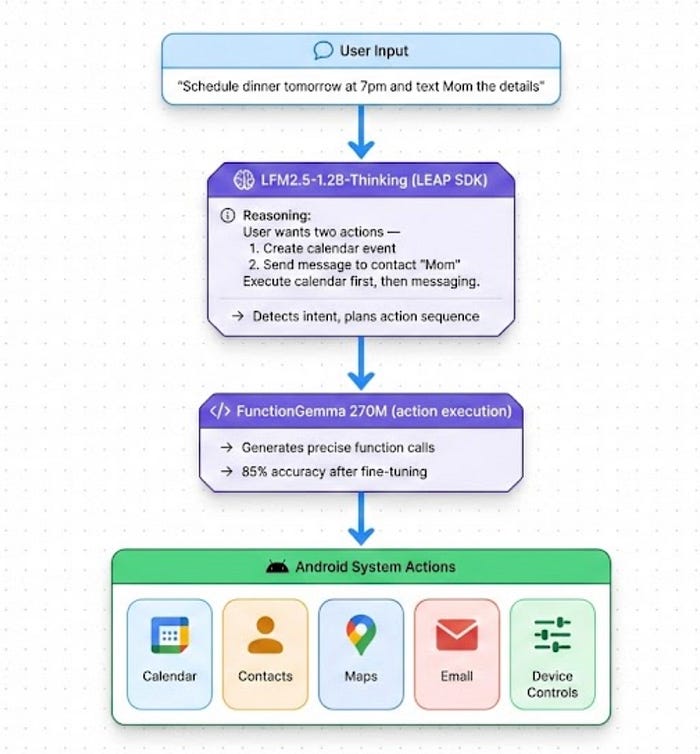

4、测试模型:个人助理演示

为了在实际中验证LFM2.5-1.2B-Thinking的能力,我构建了一个双模型移动助理:

LFM2.5-1.2B-Thinking处理推理和编排 —— 理解上下文、解决歧义、规划多步序列。FunctionGemma(2.7亿参数,使用官方Google Jupyter Notebook在Mobile Actions数据集上微调)处理精确的函数调用生成。我真正寻找了推理能力的最佳组合——特别是对于序列和完美准确的函数调用。

这种分离发挥了每个模型的优势。总占用空间:两个模型同时运行约1.5GB。它实际做什么: ➡带有流式响应的自然对话 ➡日历事件("明天8点晚餐") ➡联系人管理 ➡地图导航 ➡设备控制(手电筒、WiFi) ➡电子邮件撰写

该模型用真实推理处理复杂的多动作请求——而不仅仅是模式匹配。更重要的是,我发现LFM2.5-1.2B-Thinking擅长长上下文推理。大多数模型随着上下文增长而显著退化。LFM2.5-1.2B-Thinking即使在整个上下文长度也保持吞吐量。

5、这对边缘AI意味着什么

LFM2.5-1.2B-Thinking证明了几个重要点:

- 真实推理适合900MB。 "思考"能力不是噱头 —— 它是训练行为,仅在厄运循环减少方面就将任务性能提高了40倍。

- 带有模型合并的课程学习行之有效。 最终模型在其家谱中有25个检查点,每个都贡献特定能力。

- 参数少40%,性能相同或更好。 LFM2.5-1.2B-Thinking匹配Qwen3-1.7B,同时明显更小。

- 工具已为生产做好准备。 LEAP SDK、llama.cpp支持以及从第一天起在所有主要硬件平台上的NPU优化。

轨迹很明确:专用的小型模型将主导边缘AI。不是因为它们更便宜(尽管确实如此),而是因为它们更快、更私密,并且越来越有能力。

LFM2.5-1.2B-Thinking就是证明。

原文链接: LFM2.5–1.2B-Thinking: Liquid AI's Reasoning Model That Fits in Your Pocket

汇智网翻译整理,转载请标明出处