基于Ollama的本地图像生成

在这篇文章中,我将与您分享如何使用 Ollama 的实验性图像生成从快速终端实验构建真正的 AI 驱动工作流程。

几天前,图像生成意味着一件事:云端 API、速率限制、计费仪表板和焦虑。

然后我运行了一个命令:

ollama run <model> "a cat holding a sign that says Hello"

一张图像出现了在本地,在我的机器上。

没有 API 密钥。 没有互联网。 没有信用卡。

那时我意识到一件重要的事情:

本地 AI 不再是"未来"。它已经可用,开发人员完全适合在其上构建。

在这篇文章中,我将与您分享如何使用 Ollama 的实验性图像生成从快速终端实验构建真正的 AI 驱动工作流程。

1、什么是 Ollama 图像生成?

Ollama 最近推出了实验性本地图像生成,允许您在自己的机器上完全运行强大的文本到图像模型。

这对 Web 开发人员为什么重要:

- 无供应商锁定

- 无基于使用的定价

- 非常适合内部工具、原型和隐私优先的应用程序

如果您曾经这样想过:

"AI 很酷,但我不希望我的应用程序依赖云端账单。"

这是您的时刻。

Ollama 目前有 2 个开源模型可以在您的本地机器上生成图像。在我撰写本文时,它仅支持在 macOS 上进行图像生成,Windows 和 Linux 即将推出。

2、认识模型(为任务选择正确的模型)

Ollama 目前支持两个图像模型。它们服务于不同的目的,知道何时使用哪一个很重要。

2.1 Z-Image Turbo:首先照片写实主义

最适合:

- 写实肖像

- 摄影风格场景

- 自然光线和深度

为什么令人印象深刻:

- 6B 参数模型

- 处理双语文本渲染(英语 + 中文)

- Apache 2.0 许可 → 商业使用安全

示例提示:

Young woman in a cozy coffee shop, natural window lighting,

wearing a cream knit sweater, soft bokeh background,

shot on 35mm film

当您的提示感觉像摄影笔记——而不是关键词——时,这个模型最为出色。

2.2 FLUX.2 Klein:文本和 UI 友好图像

最适合:

- UI 原型图

- 海报和排版密集型设计

- 产品风格照片

开发人员为什么喜欢它:

- 非常擅长图像内的可读文本

- 可用 4B 和 9B 变体

- 专为速度和清晰度设计

示例:

ollama run x/flux2-klein "A neon sign reading OPEN 24 HOURS in a rainy city alley"

如果您正在构建仪表板、着陆页或设计预览,这个模型是您的首选。

3、它是如何工作的?

运行带有如下提示的命令,

ollama run x/z-image-turbo "your prompt"

图像将保存到您的当前目录。要直接在您的终端中查看图像,请尝试支持图像渲染的终端(Ghostty、iTerm2 等),它们可以直接内联预览图像。

3.1 安装 Ollama

从其 网站 下载并安装 Ollama。

3.2 拉取图像

我在本地尝试了 x/z-image-turbo:fp8 模型,它效果更好。由于这些图像模型处于初始阶段,您可能对生成的图像不满意,但在未来,我们可以看到更好的输出。

运行下面的命令拉取图像 x/z-image-turbo:fp8

ollama pull x/z-image-turbo

3.3 运行图像

一旦安装 Ollama 并拉取图像,生成图像实际上就是一个命令。

试试这些示例提示:

提示 1:

ollama run x/z-image-turbo "Surreal double exposure portrait, robot silhouette filled with blooming cherry blossom trees, soft pink and white petals floating, dreamy ethereal atmosphere, fine art photography"

接下来会发生什么:

- 模型在本地运行

- 生成图像

- 文件保存到您的当前目录

AI 生成

- 如果您的终端支持(iTerm2、Ghostty),您甚至可以看到内联预览

这是那些"等等……就这样吗?"时刻之一。

提示 2:

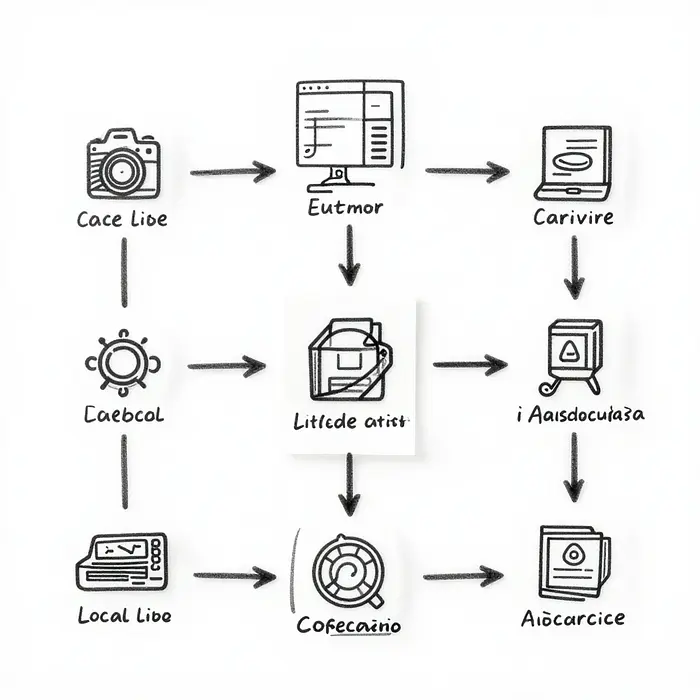

ollama run x/z-image-turbo "Whiteboard-style technical diagram explaining local AI image generation workflow, hand-drawn arrows connecting terminal → AI model → generated image, simple icons, black marker strokes on white background, minimal and clean whiteboard illustration, instructional diagram style, flat and readable, no shading, 16:9 aspect ratio"

AI 生成

3.4 控制输出(这是变得有趣的地方)

一旦模型运行,您就不会受制于默认值。

Ollama 直接在会话中公开交互式命令:

/set width 1024

/set height 1024

/set steps 30

/set seed 42

/set negative "blurry, distorted, low quality"

让我们分解一下:

- 宽度 / 高度 → 控制分辨率

- 步骤 → 更多步骤 = 更多细节(但更慢)

- 种子 → 可重现的结果(对迭代非常重要)

- 负面提示 → 告诉模型不要做的事情

这感觉更像是引导创意引擎,而不是提示。

4、用例

这是我实际上看到团队使用的场景:

4.1 开发人员的内部设计工具

- Ollama 在本地生成图像

- 图像用于:占位符资产、UI 原型、演示环境

为什么这里本地很重要:

- 离线工作

- 没有数据离开机器

- 每张图像零成本

这是自然适合 UI 开发人员工作流程的 AI 工具类型。

4.2 图像保存位置

默认情况下:

- 图像保存在您的当前工作目录

- 文件名根据提示自动生成

这使得以下变得微不足道:

- 围绕结果编写脚本

- 使用 Node.js 进行后处理

- 将输出管道输入到其他工具中

如果您曾经构建过工具,这种设计选择感觉是有意为之且聪明的。

4.3 限制

此功能仍然是实验性的:

- Windows 和 Linux 支持即将推出

- 图像编辑功能还不存在

- 模型选择仍然有限

但这里有一件事:

每个严肃的 AI 平台都正是这样开始的——简单、本地和开发者优先。

5、为什么这比你想象的更重要

本地图像生成为开发人员改变了游戏规则:

- 您可以无需后端基础设施发送 AI 功能

- 您可以比以往更快地原型化想法

- 您可以默认尊重用户隐私地构建工具

最重要的是:

您停止将 AI 视为黑盒 API,开始将其视为本地依赖项。

这种思维转变是巨大的。

原文链接: Build Local AI Image Generation with Ollama (No Cloud, No API Keys)

汇智网翻译整理,转载请标明出处